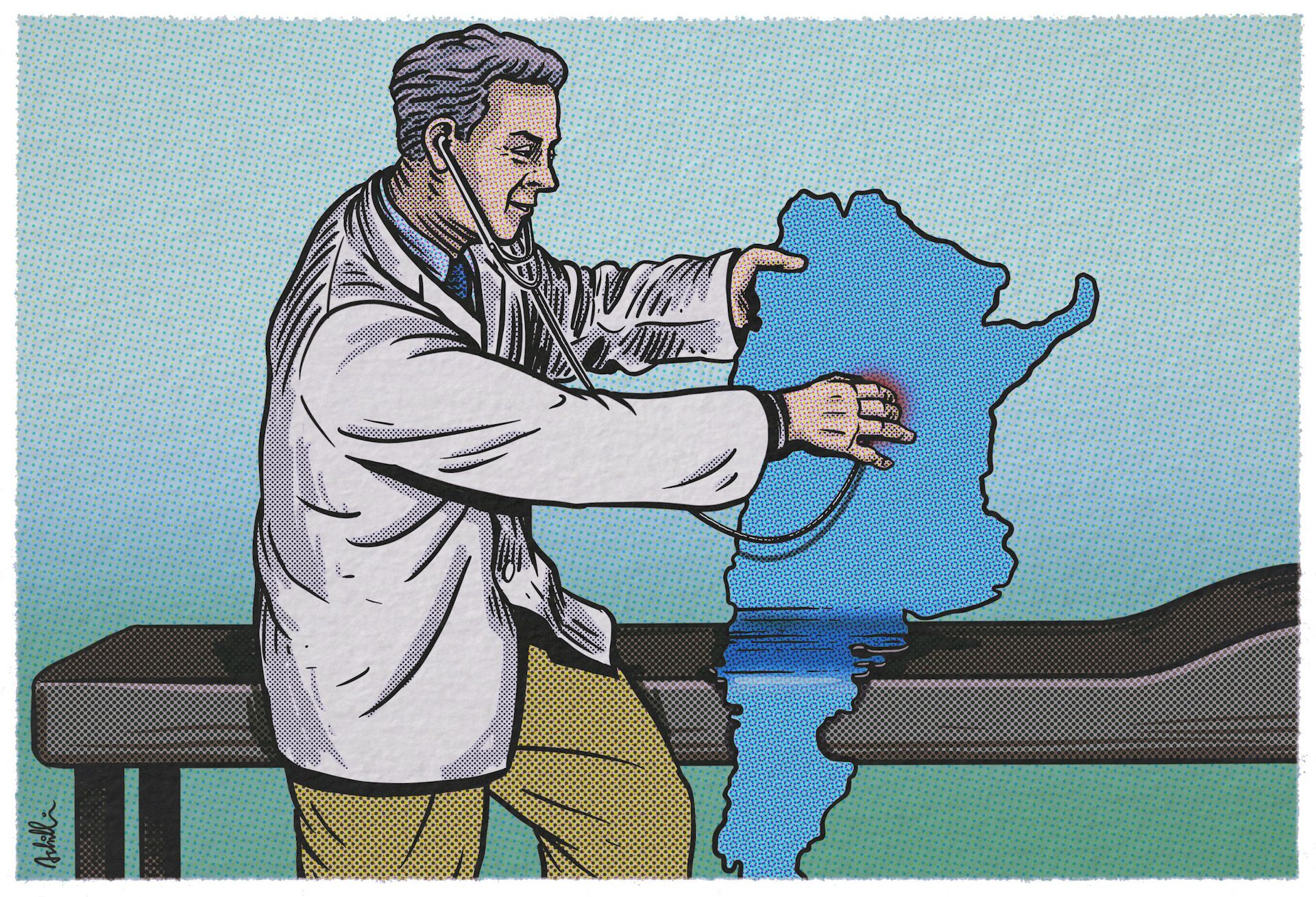

El martes pasado se publicó en la página del instituto de cálculo de la Facultad de Ciencias Exactas y Naturales de la UBA un estudio llamado “Informe sobre el Impacto de la presencialidad escolar en los casos confirmados de COVID-19”. El texto está firmado por trece autores, dos coordinadores-autores y un compilador. Todos ellos son investigadores del CONICET o de universidades nacionales y algunos también se desempeñan como asesores del gobierno de la Provincia de Buenos Aires. En los últimos días, el estudio fue ampliamente difundido por sus autores y por diversos medios periodísticos, e incluso fue recomendado por el propio gobernador bonaerense, Axel Kicillof.

El informe consiste de tres secciones. La primera intenta mostrar, a partir de datos de la Ciudad y de la Provincia de Buenos Aires, que el cierre de escuelas causó una mayor caída en los casos de coronavirus en la Provincia de Buenos Aires que en la Ciudad, donde se mantuvieron abiertas. Las segunda y tercera secciones revisan criterios epidemiológicos para la toma de este tipo de decisiones en otros países y repasan una parte de la bibliografía sobre el efecto de las aperturas o cierres de escuelas en la evolución de la pandemia. Me interesa detenerme en la primera sección, porque es la que se ocupa del caso argentino y contiene el análisis original de los autores, y hacer algunos comentarios sobre el rol de la evidencia empírica y la autoridad científica en la toma de decisiones de política pública.

diferencias no significativas

Los autores intentan determinar el efecto que tuvo el cierre de las escuelas en los municipios bonaerenses del área metropolitana. Para hacerlo, comparan la tendencia de la curva de casos confirmados en la Ciudad con la de los municipios del AMBA bonaerense. Advierten que la caída en la cantidad de casos que se observa en la semana posterior al 22 de abril, fecha que eligen por haber sido tres días después del cierre de las escuelas, es más pronunciada en el AMBA bonaerense (22%) que en la Ciudad (13%). Si no hubiera habido cierre de escuelas, dice el informe, la caída del 13% de CABA también se habría producido en el resto del AMBA, de lo que infieren que los nueve puntos adicionales de caída observados en el GBA se deben al cierre de escuelas.

Aunque no es explícito en el informe, este tipo de análisis se denomina de “diferencia en diferencias”: para determinar el efecto de alguna intervención, se compara la tendencia del grupo que recibió la intervención (en la jerga, “grupo tratamiento”), con la tendencia de un grupo que no la recibió (“grupo control”). Como la tendencia del grupo control es la que habría tenido el grupo tratamiento de no haber recibido la intervención, todo desvío respecto de la misma puede considerarse efecto de la intervención. Este es el razonamiento que los autores aplican a las regiones del área metropolitana, pero su implementación y sus conclusiones sufren de fallas muy importantes. Afirmar que la tendencia en el AMBA bonaerense habría sido la misma que la de la Ciudad si no se hubiera producido el cierre de escuelas supone que la Ciudad es un contrafáctico válido de la situación en el conurbano. Esto es problemático por al menos cinco razones.

1. Para que pueda suponerse algo así, las tendencias previas a la intervención tendrían que ser similares entre las dos regiones. Esto se conoce como “supuesto de tendencias paralelas” y es un punto de partida fundamental de cualquier análisis de diferencia en diferencias. Si bien el informe no menciona ni discute este supuesto, al mirar los datos se ve que en la semana previa al cierre de escuelas en la PBA, los casos en CABA habían aumentado 4%, mientras que en el AMBA bonaerense habían caído 8%. Esto hace muy difícil afirmar que la caída más pronunciada que se observa luego se deba al cierre de escuelas y no a cualquier factor que hiciera que los casos ya vinieran bajando en la Provincia desde antes.

2. Además del cierre de las escuelas, se adoptó otra serie de medidas, que entraron en vigencia el viernes 16 de abril e incluyeron restricciones a las actividades nocturnas y reuniones sociales, entre otras. Para que el efecto que el informe supuestamente encuentra se deba exclusivamente al cierre de las escuelas, como sus autores afirman, hay que suponer que el efecto de esas otras medidas sobre la circulación viral va a ser idéntico en las dos regiones. Este supuesto, además de muy implausible, no es discutido en en el informe.

3. Para que la Ciudad sea un buen contrafáctico del resto del área metropolitana para identificar el efecto del cierre de escuelas, se necesita que absolutamente todo lo demás se haya mantenido constante en ambos distritos, salvo la presencialidad escolar. La diferencia en las tendencias previas al cierre en una región y otra sugiere que esto es seguramente falso. Sólo por mencionar una de muchas cosas que podrían haber variado, para que los cambios que se observan sean reflejo de un cambio real en la incidencia del virus, se necesita que la estrategia de testeo se mantenga constante antes y después del cierre de las escuelas. Tanto CABA como PBA anunciaron programas de testeo a personal escolar, sintomático o no sintomático. ¿Estos programas continúan cuando se interrumpe la presencialidad escolar? Si no continúan, ¿cómo se puede afirmar que la evolución del número de casos confirmados no está afectada por esa interrupción o por cualquier cambio en la política de testeo? Este supuesto es exigente, pero necesario para poder sostener las afirmaciones que se hacen sobre el impacto del cierre de escuelas. Tampoco es discutido en el informe.

4. En el informe se sostiene varias veces que las diferencias encontradas entre el AMBA bonaerense y la CABA son significativas. En todo estudio de impacto, y en general en todo análisis de datos con ambición de identificar efectos causales, se apoyan estas afirmaciones con pruebas de hipótesis. Estas permiten calcular en qué medida resultados como los registrados podrían ser observados aun si la hipótesis del estudio fuera falsa. En otras palabras, cuánta confianza podemos tener en que los resultados son reales y no producto de simple ruido estadístico, cálculo que se conoce como de significatividad estadística. El informe no muestra ninguna prueba de hipótesis ni cálculo de significatividad estadística, a pesar de repetir en varios momentos que los resultados encontrados son, quizás en algún otro sentido, significativos.

5. Relacionado con varios de los puntos anteriores, el informe no hace nada para descartar hipótesis alternativas. Si, como supone el informe, CABA y el resto del AMBA tuvieron dinámicas semejantes hasta el cierre de escuelas y toda divergencia posterior a eso se puede atribuir al cierre, reproducir el mismo análisis usando fechas anteriores al cierre de escuelas debería arrojar resultados nulos. Este tipo de chequeo se conoce como test de placebo, ya que uno no debería encontrar resultados cuando no se realizó ninguna intervención. El informe no hace esto ni discute hipótesis alternativas, pero los gráficos que incluye no lo favorecen, porque muestran que la tendencia a la baja en la cantidad de casos precedió al cierre de escuelas en los municipios bonaerenses, pero no en CABA.

estándares mínimos

Los puntos de arriba no son exigencias detallistas sino requisitos muy elementales incluidos en cualquier estudio de impacto con la ambición de identificar efectos causales, en cualquier disciplina. Lamentablemente, el informe no está a la altura de esos estándares mínimos. Afirma con liviandad relaciones causales que no sustenta con evidencia, propone un diseño de investigación cuya validez depende de varios supuestos que difícilmente cumple y nunca discute, no menciona hipótesis alternativas ni posibles problemas en sus hallazgos, no justifica las comparaciones que hace ni los indicadores que usa.

Tampoco se puede aducir, como sugirió alguno de los autores, que el informe no debe ser sometido a los mismos estándares que un trabajo científico o académico. El documento está escrito por un grupo de investigadores que firman en tanto científicos, y publicado en el sitio de un prestigioso instituto de una universidad nacional. Es correcto exigirle el mínimo rigor que un estudio de esa ambición debería mostrar, porque inevitablemente sus conclusiones van a aparecer respaldadas por la autoridad y el prestigio de sus autores y el de las instituciones donde se desempeñan. Previsiblemente, el informe circuló en redes y medios de comunicación como “el informe del CONICET”. Si bien no existe tal cosa como un “informe del CONICET”, esto muestra que sus conclusiones fueron tratadas con la autoridad que se espera de las instituciones científicas de mejor reputación, de modo que es razonable tener con él la mínima exigencia que esa autoridad merece.

Es una buena noticia que la discusión de política pública esté informada por la evidencia empírica, pero en este informe la conclusión parece haber precedido al análisis.

Es una buena noticia que la discusión de política pública esté informada por la evidencia empírica, pero en este informe la conclusión parece haber precedido al análisis. Varios autores del documento defendieron sus conclusiones argumentando que, como son consistentes con algunos estudios preexistentes y (vagamente) con lo observado, es razonable considerarlas verdaderas. O que sus resultados son tan claros a simple vista que es innecesario hacer pruebas de hipótesis para verificar su significatividad. Esto es problemático y contrario a la forma como se formulan y descartan hipótesis en el método científico. En realidad, es responsabilidad de los autores que proponen una hipótesis ofrecer evidencia suficiente en su favor y esforzarse en descartar las alternativas. El informe no permite concluir que existe una relación, ni positiva ni negativa, entre presencialidad escolar y contagios, independientemente de que tal relación exista.

Estas críticas no implican que los estándares de la evidencia para la toma de decisiones en políticas públicas tengan que ser de la misma exigencia de los de un reporte científico. Muchas veces, esta exigencia es difícil de satisfacer, pero la urgencia o la necesidad demandan que se tomen decisiones. Cuanto más alimentadas por la evidencia, aunque no sean artículos en revistas con referato o tesis de doctorado, mejores serán esas decisiones. No es bueno, sin embargo, afirmar relaciones causales cuando ni la evidencia ni los métodos empleados lo permiten. Es mejor, en todo caso, reconocer las limitaciones de la evidencia antes que exagerar las conclusiones que se pueden extraer de ella.

No es bueno, sin embargo, afirmar relaciones causales cuando ni la evidencia ni los métodos empleados lo permiten.

Por último, creo que es necesario poner en contexto los eventuales beneficios de los cierres de escuelas para contener la transmisión de la enfermedad y considerar también sus costos. Así como hay, no en este informe pero sí en otros estudios, evidencia sobre la relación entre presencialidad escolar y circulación del virus, también hay evidencia acumulada sobre los grandes costos que estos cierres comportan. Además de generar grandes pérdidas de aprendizaje y de vinculación escolar, se sabe que impactan más negativamente en alumnos de nivel socioeconómico más bajo, con peor conectividad y menos apoyo en el hogar, además de afectar peor a las mujeres. La discusión sería más productiva si se consideraran todos los aspectos de esta política. Lamentablemente, la escolaridad en Argentina parece no tener la prioridad que su importancia merece. Según datos de UNESCO, a fines de marzo Argentina estaba en el 8% de los países con más semanas de escuelas cerradas durante la pandemia. Para una conversación más productiva sobre los cierres de escuelas se deberían tener en cuenta sus costos y discutir si es razonable que a la educación se le impongan criterios precautorios más exigentes que a otras actividades.

Proveer acceso universal a educación de calidad es fundamental para el desarrollo de nuestro país. Al mismo tiempo, mitigar el impacto de la pandemia es una urgencia inmediata. Analizar datos para tomar decisiones en ámbitos de tanta relevancia es una iniciativa siempre bienvenida. Sin embargo, cuando estos análisis no tienen el rigor que el tema amerita y, además, son difundidos como si se tratara de estudios con estándares científicos de calidad, el daño puede ser mayor que los beneficios. Tomar estos temas con la seriedad que merecen también implica llevar adelante las investigaciones con el mayor rigor posible y comunicar sus resultados de forma honesta y responsable.

Si te gustó esta nota, hacete socio de Seúl.

Si querés hacer un comentario, mandanos un mail.